硬件童话——讲述显卡自己的故事(中)

电脑学堂

认识AGP显卡

我们独立显卡家族从PCI显卡一路发展而来,目前人丁最兴旺的是AGP显卡,它们与PCI-E显卡从外观上看是没有多大区别的,外观上最大的不同在于接口——AGP显卡所用的AGP接口比PCI Express×16接口要短一些。下面我主要跟大家讲一下AGP接口及另外一个很有特色的元器件——桥接芯片。

1.AGP接口的演进

作为图形图像加工工厂,我们的“生产原料”是由CPU发送过来的信号,输入“原料”的通道就是外部接口。在AGP总线出现之前,PCI总线就是我们与 CPU连接的通道,但它的工作频率只有33MHz,带宽也只有133MB/s,限制了我们的3D性能发挥。为了解决电脑处理3D图形能力差的问题,Intel提出了AGP接口(AGP是英语“加速图形端口”的缩写),AGP总线将我们和北桥芯片直接连接起来,让我们摆脱了PCI总线的束缚,能够自由发挥性能。

AGP就像我们与主板联系的“高速公路”,根据高速公路的“车道数量”和“行车速度”划分为AGP 1.0(AGP 1×、AGP 2×)、AGP 2.0(AGP 4×)、AGP 3.0(AGP 8×)等三个标准。

(1)AGP 1.0规范

AGP 1.0规范由Intel于1996年7月发布,它规定的工作频率为66MHz,工作电压为3.3V,分为1×和2×模式,数据传输带宽分别为266MB/s和533MB/s,由于带宽很小,如今已经被淘汰了。

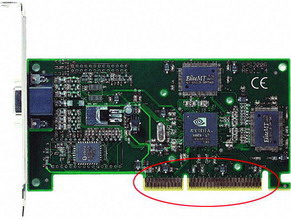

早期的AGP显卡成员都采用AGP 1.0接口,AGP 1.0接口被一个缺口划分为两个部分,而且其“缺口”也处于金手指上靠近挡板的一侧。

(2)AGP 2.0规范

1998年5月,AGP 2.0规范正式发布,规定的工作频率依然是66MHz,但工作电压降低到了1.5V,并且增加了4×模式,数据传输带宽达到了1066MB/s。

AGP 4×显卡与AGP 2×显卡接口的长度是一样的,它们最大的区别就是AGP 4×显卡的金手指部位有两个缺口,由这两个缺口将金手指分成了三段。

通过AGP 4×显卡的金手指大家可以看出,这类成员向下兼容AGP 1.0规范——偏左的那个缺口与AGP 1.0显卡的那个缺口位置是一样的,因此完全可以将AGP 4×显卡插到符合AGP 1.0规范的插槽上。

(3)AGP 3.0规范

AGP 3.0是最高速的AGP规范,采用AGP 8×模式。AGP 8×的总线速度为66MHz×8=533MHz,数据传输带宽达到了2.1GB/s。

初期的AGP 8×显卡的金手指与AGP 4×的是一样的,也向下兼容AGP 4×、AGP 2×等模式。不过,很多采用AGP 8×接口的新显卡,其接口并不向下兼容AGP 1.0规范(但兼容AGP 2.0规范),为了防止人们将这类成员插入AGP 1.0规范的插槽中,它们的外部接口只有一个缺口,并且在远离挡板一侧。

2.采用桥接芯片的AGP显卡

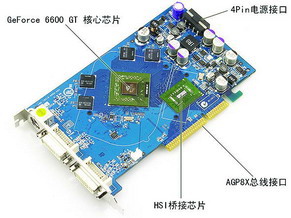

随着技术的进步和图形处理要求的进一步提高,AGP接口已经不能满足我们性能发挥的需要,目前的部分独立显卡家族成员开始采用PCI-E总线接口,不再支持AGP。不过,由于市场上还有很多使用AGP接口的主板,于是便出现了一种特殊的AGP显卡——利用“桥接芯片”使本身只支持PCI-E接口的显卡使用AGP接口,例如AGP版的GeForce 6600 GT、GeForce 6600等显卡就是这样的产品。

这类成员的身体上除了显示核心外,在显示核心与AGP接口之间还有一块比较大的芯片——桥接芯片。该芯片起着“桥梁”的作用,它把PCI Express×16总线转换成了AGP 8×总线。

提示:虽然这类本身支持PCI Express×16总线的显示核心拥有4GB/s的带宽,但由于实际采用的是AGP 8×接口,因此显示核心的实际外部接口带宽是AGP 8×所提供的2.1GB/s。此外,由于桥接芯片本身存在一定的损耗,理论上讲,显示核心的外部接口带宽还会低于2.1GB/s。

了解PCI-E显卡

相信大家已经知道,随着显卡接口的进步,PCI-E显卡将逐渐成为主流,因此我们再来看看PCI-E显卡。

1.PCI-E接口

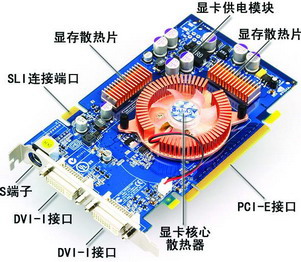

由于AGP接口的带宽已经无法完美发挥我们的性能,独立显卡家族的部分成员开始采用PCI-E这种新型外部接口。因为PCI Express×16的总线带宽可以达到4GB/s(双向8GB/s),因此这部分家族成员都是采用的PCI Express×16接口。从外观上来看,PCI Express×16接口比较长,在接口靠近挡板的一侧有一个“缺口”。

2.SLI连接端口

在那些采用NVIDIA高端显示核心的PCI-E显卡成员(如GeForce 6600GT)身上,往往能够看到一个比较短的连接端口。这个端口就是所谓的“SLI端口”。

SLI的中文意思是“可扩展连接接口”,它是NVIDIA推出的一项显卡性能增强技术。通过该技术,可以在主板上同时安装两块支持SLI的显卡,让两个家族成员同时工作,使图形性能翻番。

显卡是否具备SLI技术是由显示核心决定的,因此并不是所有的PCI-E显卡都有SLI端口,目前具备该功能的显卡是NVIDIA公司的GeForce 6800系列、GeForce 6600 GT等。这类显卡还要配合nForce4 SLI主板才能让两块显卡同时工作。

看清显示核心

1.显示核心的作用

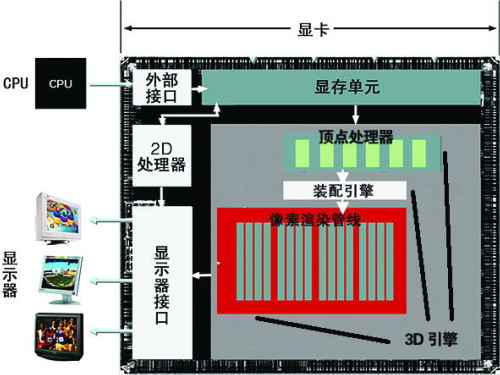

上期说过显示器上所显示的画面,是由一个个像素点组成的,而这些像素点相应的信号都是经过我们的大脑——显示核心处理后提供给显示器的。在显示数据处理过程中,需要处理的2D数据会直接进入显示核心的2D处理器,经过2D处理器处理后,输出到显示器。而3D图形数据将会进入显示核心内部的3D引擎,3D引擎会根据3D图形数据“描绘”出3D图像,然后输出到显示器。

从显卡的内部结构来看,最重要的就是3D引擎、2D处理器等处理单元,而这些核心部件全部集中在我们的大脑——显示核心中。

显示核心与CPU一样,技术含量相当高,有能力设计开发显示核心的厂商非常少,目前全球最主要的显示核心开发厂商是NVIDIA和ATi两家。NVIDIA和ATi这两家厂商主要为独立显卡提供显示核心,而Intel、VIA、SiS等主板芯片组厂商则在集成显卡市场呼风唤雨。

2.显示核心内部结构

(1)2D处理器

从结构上来看,2D处理器、3D引擎是显示核心中最关键的部分。目前的电脑既需要处理2D图像,同时也需要处理3D图像。因此,我们的大脑内部主要分为2D处理与3D处理两大块。

2D图形数据的处理相对比较简单,目前显示核心的2D处理技术已经非常成熟。通过一个2D处理器,即可完成这项工作。

(2)3D引擎

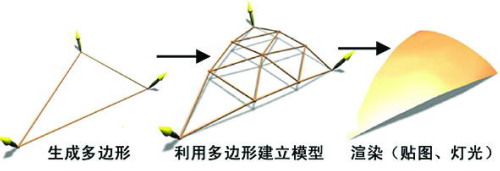

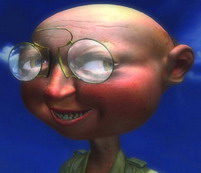

相对2D图形数据,3D指令和数据的处理就要复杂多了——电脑显示3D图形的过程时首先是用多边形(三角形)建立一个三维模型,然后再根据相应的指令来将这个三维模型进行着色、阴影、打光等其他处理,最后才能生成栩栩如生的3D图像。

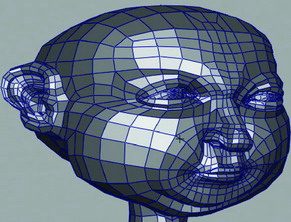

3D数据由显示核心内的3D引擎来进行处理,在3D引擎内部,主要有两个主要的功能部件——顶点处理器、像素渲染流水线。

所谓“顶点”就是那些描述3D图形空间位置的数据。3D引擎工作时先从显存中将描述3D图形外观的顶点数据读出,根据这些三角形顶点数据以及像素Z值、Alpha值来确定3D图形大致的外观以及不同物体在空间上的纵深关系。形成的这个外观图像就像“风筝”的骨架一样,不同物体之间呈现的空间关系也因为此时还没有光影变化以及凹凸贴图所表现的层次感,看起来就像人眼具有透视功能一样,可以透过前面的物体看到后面的物体,这个处理过程可以理解为“建立模型”。

在外形确定之后,接着便从显存中读取纹理数据,将工作交给像素渲染流水线进行合成处理,即为“风筝”糊上“外衣”并着色,同时光影效果、阴影过渡也在这个阶段计算出来,完成这两个阶段之后将处理好的数据放入显存或直接输出到显示器。

小知识

显示核心的工作频率

与CPU一样,显示核心的工作频率直接关系到它的性能,相对于CPU动辄上GHz的频率,目前显示核心的工作频率大都在200MHz~600MHz之间。当厂商开发出一款显示芯片后,会根据工作频率的高低来划分挡次,并分别标上不同的型号进行出售。一般显示芯片厂商会规定一个型号的显示芯片的核心频率,但事实上有些小厂的产品却有可能达不到规定的核心频率,而有些大厂的产品则会将核心频率再提高一点,以便获取更好的性能。