2006年数据储存技术展望

IT技术回顾

自诞生那天起,存储设备便在不断突破着速度和容量的极限,在所有计算机硬件中,存储设备的发展速度丝毫不慢于CPU和图形卡。那么,2006年又会有什么样的存储技术让我们充满期待?又会有什么样存储产品再次改变我们的生活?

一、内存技术展望

观察计算机硬件发展的朋友一定知道,目前配件中图形核心和处理器的发展是最为迅速的。如果与之搭配的周边硬件出现瓶颈,那对于图形核心和处理器来说是致命的打击,因为这意味着大量资源由于没有足够大的数据带宽为其提供任务和将已经处理好的任务输出而白白浪费掉,所以发展图形核心和处理器的同时还要发展显存和内存技术才能达到预期的效果。在2005年完成了存储容量的竞争之后,2006年内存产品将会在速度和带宽上展开较量……

1.Rambus卷土重来——XDR2

对于Rambus所主导的RDRAM想必大家已有所了解,由于其具有超前的串行传输设计而需要对内存底层技术做出彻底的改订,因此受到了主流市场用户的抵制,就连Intel这样的巨头,经过力推RDRAM失败之后也只好向主导DDR规格的JEDEC妥协。

但是Rambus并没有被消灭,而是潜心做研发并在2003年7月10日,发布了自RDRAM之后的第二代串行传输内存技术——XDR(即eXtreme Data Rate,极限数据传输率内存),并得到了SONY公司的大量游戏机订单。根据Rambus对产品的规划来看,XDR准备于2006年再次全面进入桌面台式机,而这次与上一次相比可能会有所不同,这次Rambus瞄准了显卡领域。为了应对显卡对数据带宽越来越高的要求,时隔两年后的2005年7月7日,Rambus发布了本文的主角也就是XDR2,准备与GDDRIII做出较量。

(1)XDR2架构介绍

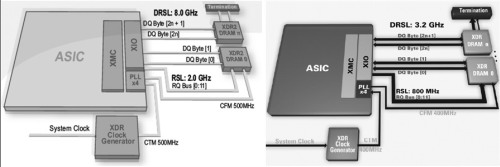

虽然XDR在架构上与Rambus公司上一代产品RDRAM相差太大,但是XDR2与XDR相比则显得很相似。在介绍XDR2之前,我们先通过XDR2与XDR架构图的对比了解一下XDR2在XDR基础之上做出了哪些改进与优化。

从图中我们可以看到,XDR2与XDR系统在架构上整体的差别并不大,主要不同只是体现在相关总线的速度设计方面。首先,XDR2将系统时钟的频率从XDR原有的400MHz提高到500MHz;其次,在用于传输寻址与控制命令的RQ总线(RQ Bus)上,工作频率从800MHz提升至2GHz,也就是XDR2系统时钟的4倍;最后,得出的效果便是数据传输频率由XDR的3.2GHz提高到8GHz,即XDR2系统时钟频率的16倍,也正是如此,Rambus将XDR2的数据传输技术称为16位数据速率(HDR,Hex Data Rate)。Rambus表示,XDR2内存芯片的标准设计位宽为16Bit(它可以像XDR那样动态调整位宽),如果按每个数据引脚的传输频率为8GHz,一枚XDR2芯片的数据带宽就将达到16GB/s!与之相比,目前速度最快的GDDRIII-800的芯片位宽为32Bit,数据传输率为1.6Gbps,单芯片传输带宽为6.4GB/s,这样的成绩只有XDR2的40%左右,显然无法和XDR2抗衡。

(2)优秀的MT构架设计

XDR2在设计之初就是瞄准了显示卡领域,而在这一应用过程中经常会访问一些容量小、数量大的离散型数据,XDR2架构的一大创新就是针对这一操作进行架构优化,Rambus称之为微线程架构(MT,Micro- Theaded)。从理论上,要针对这种容量小、数量大的数据类型做出合适的设计就要减少行与列的访问颗粒度——XDR2首先就要将内存架构中行与列的访问间隔缩小;其次就是减少每次列数据输出的容量。第一,XDR2在工作频率方面进行改进,其将命令与RQ总线的工作频率提升至2GHz,换句话说,就是在原有一个时钟周期内,理论上可以发送4条命令;第二,在XDR2的DRAM设计方面,虽然也采用了A+B双数据通道的设计,并且将逻辑Bank(L-Bank)从XDR的8个增加至16个,但是A和B两条数据通道是各自独立的,各自连接8个逻辑Bank。这样设计的目的就是实现交错寻址,降低行与列的访问颗粒度。

(3)XDR2辅助技术

XDR2除了优秀的MT架构以外,为了保证其稳定的运行在高频率下还继承了XDR的诸多优点并加入了新的辅助设计,下面就让我们对其中比较重要的设计做一个简单了解。

FlexPhase(弹性相位):FlexPhase技术开发的初意是使内存生产者不再费力地去校正PCB的布线设计以减少延迟或潜伏期等因素对数据同步的影响,而FlexPhase技术使信号本身就已经具备了数据/时钟同步与自校正的能力,从而使外围设计与布线变得非常简单,并有助于提高同步性和提高总线利用率。

Dynamic data width(动态位宽):与XDR 内存一样,XDR2可以动态调整接口的位宽,这样一来允许接口的位宽有2Bit、4Bit、8Bit等模式选择,有助于提高系统设计的灵活性。另一方面,当位宽改变以后访问颗粒度也将会改变(2Bit、4Bit、8Bit时的列访问颗粒度分别对应2字节、4字节和8字节)另外带宽也降至2GB/s、4GB/s和8GB/s。

Zero Overhead Refresh(刷新零占用率):传统的DRAM刷新过程是对所有逻辑Bank的相同地址行进行刷新,如果正好遇上某一行处于运行状态时,工作中的逻辑Bank就会与刷新操作产生冲突。而由于XDR2内部独特的逻辑Bank设计可以通过交错控制刷新过程,从而避免了刷新操作影响DRAM正常工作的情况。

2.JEDEC阵营的看家武器——DDRIII

某些有实力的厂商在今年年中宣布其成功研发出DDRIII内存标准,由此也可以看出,DDRIII的设计确实已经接近尾声,明年的上市应该是情理中的事情。这样看来,从DDRII发展到DDRIII只是时间问题而已。接下来我们就一起来了解一下DDRIII在DDRII的基础之上有了哪些变化与改进。

(1)DDRIII预取的变化

从DDRII开始内存模块中数据传输频率和内核工作频率便有所不同了,造成这样的主要原因在于预取位数的增加。DDRII内部的预取为4Bit,这样一来,在内核工作频率为200MHz的情况下其数据传输频率能够达到800MHz。想再进一步提升其内核频率的就显得有些困难了,在产品的生产难度和成本方面都无法保证。于是JEDEC阵营新一代看家武器DDRIII亮相于众,为了使内存模块数据传输频率进一步提高,DDRIII采用了8Bit预取,较DDRII有了一倍的提升。规格为DDRIII-800的内存模块,虽然其数据传输频率为800MHz,但是内核频率仅仅为数据传输频率的八分之一,有效控制了生产过程中的难度与成本。

(2)DDRIII拓扑结构变化

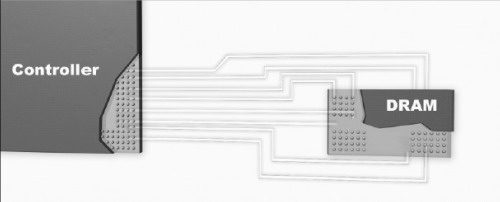

DDRIII内存模块较DDRII相比在数据传输频率方面有较大的提升,如果还是使用DDRII原有的拓扑结构,势必会造成不良的效果,所以JEDEC为DDRIII模块开发了一种全新的点对点(P2P,Point-to-Point)的拓扑结构以满足数据传输频率较高的要求,同时也可以减轻地址/命令与控制总线的负担。

点对点的拓扑结构设计是为了提高系统性能而进行的重要改动,也是DDRIII与DDRII差别的一个关键。在DDRIII系统中,一个内存控制器将只与一个内存通道通信,而且这个内存通道同样也只能有一个内存模块插槽,这样便形成了一种内存控制器与DDRIII内存模组之间点对点的对应关系,或者是点对双点 (P22P,Point-to-two-Point)的关系,从而大大减轻了地址/命令与控制数据总线的负载。

(3)DDRIII功耗的改进

功耗在目前电脑领域来看是一个相当热门的词语,世界上很多权威硬件媒体在全面评测一款产品的时候一定不会忘记这方面的评比。现在评价一款产品好坏与否,不仅要看其性能还有看其是否拥有出色的功耗表现。JEDEC当然也清楚这一点,将DDRIII的工作电压从1.8V降低到了1.5V。另外,JEDEC还在DDRIII引入了重置(Reset)功能,虽然这一项功能是DRAM很早就要求加入的。当加入Reset命令以后工作模式有一定变动,Reset命令有效时,DDRIII内存将停止所有的操作并切换至工作量最少的状态,以节约电力;而在Reset期间,DDRIII内存将关闭绝大多数的功能项,所有数据接收与发送器都将被关闭。这样一来,将使DDRIII的节能目的达到较好的效果。

(4)DDRIII容量与封装

DDRIII在容量方面,由于使用了最小为8个逻辑Bank的设计,所以其容量应该从2GB起步,随着技术的成熟将会出现以16个逻辑Bank设计的DDRIII内存规格,这样一来容量将会更大。DDRIII由于新增了一些功能,所以在引脚方面会有所增加——8bit芯片采用78球FBGA封装;16bit芯片采用96球FBGA封装。DDRIII必须是绿色封装,不能含有任何有害物质。

3.串行的新力量——FB-DIMM

严格来讲,FB-DIMM 是在DDR2、DDR3基础之上发展出的一种新型模组架构,所以可以断定FB-DIMM推出时受到的压力肯定要比RDRAM推出时候少得多。Intel将FB-DIMM最初定位在服务器领域,但是并不排除由于桌面台式处理器带宽需求量巨大而将FB-DIMM引入到其中。下面就让我们看看FB-DIMM有哪些过人之处。

(1)何谓FB-DIMM

在了解清楚什么是FB-DIMM之前,首先来了解一下传统服务器所使用的Reg-DIMM。服务器领域所使用的Reg-DIMM与我们日常使用的Unb-DIMM最大不同在于前者有寄存器而后者没有,这样的设计便造成了Reg-DIMM可以设计出高容量模组以便使用在需要大容量内存和要求命令与寻址信号有较好的稳定性的工作场合中。简单地理解,寄存器的作用就是稳定命令和地址信号并隔离外部干扰,使其能有一个较为稳定的工作过程,这对于服务器来说是很重要的一个环节。

当Reg-DIMM开始工作时,命令地址信号会先送入寄存器进行“过滤”并形成一个密封的状态,随后再发送至内存芯片;但是当内存芯片中的数据需要传输到北桥的时候并不会通过这颗“过滤”装置。由于要经过寄存器这颗“过滤”设备,所以内存操作的时序会比日常所使用的多出一个时钟周期,但在服务器领域中,内存系统的稳定性远远在性能之上,所以这样的设计是能够理解与接受的。

Reg-DIMM内存结构图

与传统的Reg-DIMM只是在Unb-DIMM上加装寄存器、PLL等元件相比,FB-DIMM与Unb-DIMM有了很大的变化。首先,FB-DIMM与内存控制器之间的数据与命令的传输不再是传统的并行方式而是采用了类似于PCI-Express的串行传输方式多路并联的设计。这样设计带来的好处是可以实现上行10路并联(位宽10bit)和下行14路并联(位宽14bit)的数据串行传输模式。另外,从FB-DIMM工作模式图中还可以看出,每个DRAM芯片不再直接与内存控制器进行数据交换,除了时钟信号直接与系统管理总线连接外,其他的命令和数据的I/O都要经过位于FB-DIMM上的内存缓冲器的中转。

(2)FB-DIMM优势所在

目前所使用的DIMM都采用了一种名为Stub-bus(短线连接)的拓扑结构,这种拓扑结构中每个芯片与内存控制器的数据总线都有一个短小的线路相连,这样会造成电阻的不继续性,从而影响信号的稳定与完整,这样的负面影响随着频率越高或芯片数据越多而变得越大。随着以后内存时钟频率越来越高,这种结构对内存通道内的芯片数量的限制作用也越来越大。根据Intel统计表明,在1999年每个内存通道可以容纳140个内存芯片;而到了2005则下降到了70个;预计到2007年会进一步下降到20个左右。但是在FB-DIMM架构中,每个DIMM上的缓冲区是相互串联的,并且每颗DRAM芯片之间的连接模式为点对点,这样一来,数据会在经过第一个缓冲区后传向下一个缓冲区保持稳定,从而有助于容量与频率的提升。

另外,因为FB-DIMM内存模块采用了串行数据传输的设计,使FB-DIMM的引脚数大为减少。目前的DDRII Reg-DIMM的引脚数为240只,与之相比,FB-DIMM还不到其1/3,对同步的要求大大简化,有助于提高布线设计的效率并降低电路板设计的难度。

二、硬盘技术展望

平台串行化的革命毫无例外地波及到了存储领域。自2005年串行存储先锋SATA成功淘汰PATA之后,2006年里同属串行家族的SAS也将对老旧的SCSI发起挑战。随着IO接口瓶颈被迅速打破,硬盘本身的低效率和低可靠性开始为人诟病。在2006年里我们能告别烦人的硬盘寻道声?摆脱数据丢失的恶梦吗?

1.SATA 2.5、SAS全面出击

2005年绝对是SATA全面普及的一年。在2005年上市的所有主板都有意无意地削减了普通PATA控制器通道而增加了更多SATA通道。Intel全系列PCI Express平台都只为用户提供一个PATA通道连接光驱,而硬盘则全部采用SATA连接。2005年许多厂商还纷纷推出采用SATA接口的光存储设备。在各个厂商强推之下,SATA迅速占据了桌面硬盘市场的半壁江山。

随后NVIDIA nforce4芯片组首次将SATA 3Gb/s的概念引入桌面平台。所谓SATA 3Gb/s其实就是将SATA接口速度从原来的1.5Gb/s提升到了3Gb/s,同时加入NCQ(本机命令排序)的支持。与此同时新一代的硬盘产品也开始全面支持SATA 3Gb/s和NCQ功能。

相对于SATA 1.5Gb/s,SATA 3Gb/s规范仅仅是将传输速度提升了一倍——事实上作为一种串行结构的接口标准,SATA只需要提升频率就能实现更高的传输率。而这一切仅仅取决于SATA控制器和SATA硬盘的支持而已。随着Intel 945/955x系列加入对SATA 3Gb/s的支持,许多人开始惊呼SATA II时代的到来,结果真的是这样吗?

在2006年,无论是SATA II还是SATA 3Gb/s标志或者所谓的标准都将会逐步消失在人们的视野里。在2005年底,由于滥用SATA II、SATA 3Gb/s进行宣传的厂商越来越多。而事实上SATA II并不是一个独立的标准,是一组规范的集合——NCQ(Native Command Queuing,本机命令排队)和3Gb/s等都包括在内,作为SATA标准的管理组织SATA-IO(Serial ATA International Organization,串行SATA国际组织,原SATA工作组)在秋季宣布,已经完成新一代SATA标准的订立,并且将会把这个标准称作SATA 2.5。

SATA 2.5规范囊括了原先SATA Ⅱ拥有的大部分功能,如3Gb/s的传输率、本机命令排序、交错启动(Staggered Spin-up)、热插拔(Hot Plug)、端口多路器(Port Multiplier)和外部SATA接口(eSATA)等。在2006年我们将会看到大量符合SATA 2.5标准的存储设备、主板上市。而SATA 2.5标准的确立和普及也标志着SATA技术的彻底成熟。2006年让我们彻底和PATA说再见吧。

桌面市场上SATA正在快速地淘汰PATA,而在高端服务器、工作站市场上,一场串行的革命也如火如荼。和PATA一样叱诧风云的SCSI接口由于并行的工作特性已经遇到了性能发展的瓶颈,此时全面转向串行技术的SAS诞生了。SAS是Serial Attached SCSI的缩写,即串行连接SCSI。作为新一代高端串行存储接口,SAS打破了以往ATA和SCSI水火不相容的局面,采用了一种兼容并包的协议架构。

SAS规范能够兼容SATA接口,而SAS控制器更是可以同时兼容SAS和SATA两类硬盘。在物理接口方面,SAS更是通过巧妙的布局能够与SATA设备兼容。我们甚至可以把SATA硬盘直接插在SAS控制器上使用。初期单端口SAS将会提供3Gb/s(大约300MB/s)的传输率。与此同时,两个SAS接口之间还可以建立起由多个物理链接构成的Wide Link。所谓Wide Link实际上就和PCI Express中的X1、X2一样通过绑定一定数量的连接从而达到更高的吞吐量。SAS问世初期将会提供2X~4X全双工Wide Link支持——这意味着在必要的时候,一款SAS接口硬盘能够获得24Gb/s(4端口×3Gb/s每端口×2)的惊人带宽!

在连接距离方面,由于SAS先天的串行优势,能够轻易的获得8米的传输距离,通过扩展器更是能够达到35米的有效距离。这样SAS就能够实现更为复杂的网络部署,更多地使用机箱外连接。

2.固态存储走入大众视野

自从IBM发明了温彻斯特原理用来存储数据之后,硬盘的基本结构和工作原理几十年来都没有发生任何的变化。时至今日,硬盘已经成为PC系统内唯一以机械方式运行的硬件。机械方式运作的硬盘首先面临的考验就是稳定性。随着使用时间的增加,硬盘各个部件都存在一定程度的损耗。而机械运作方式,也注定硬盘对于震动、温度等环境变化相当敏感。几乎所有人都有过硬盘损坏、数据丢失的惨痛经历。硬盘遇到的第二个考验便是速度问题,硬盘主轴转速不可能无限提升,而盘片/磁头的构造也注定限制了硬盘体积和读取速度。硬盘已经成为整个PC中最大的瓶颈。

为了解决硬盘的瓶颈问题,各大硬盘制造商纷纷更换接口、提升转速、加大缓存,但这些方法的效用并不明显。另一方面,随着制造工艺的完善,闪存芯片和内存芯片的价格也一跌再跌。于是有人开始打起了闪存的注意。早在2000年M-System就推出了他们的第一代4GB固态硬盘,所谓固态硬盘实际上就是把众多闪存芯片连接起来获得超大容量,同时搭配SCSI等硬盘接口。时至今日,专业领域的固态硬盘容量已经扩展到了74GB。由于采用闪存芯片作为存储媒介,固态硬盘没有任何的机械运作部件,因此固态硬盘根本不怕震动,也不会经常出现机械损坏导致数据丢失。

另一方面,无论是闪存还是内存芯片在数据访问和写入过程中都没有任何机械运动。这就意味着这些固体硬盘所谓的“寻道时间”几乎可以忽略不计。而且传输率曲线也不会因为数据的存放位置不同而波动。固态硬盘更大的优势还在于存储芯片能够轻易地实现多通道读取,许多固态硬盘的持续传输率都能超过100MB/s,使硬盘的IO接口瞬间成为瓶颈。

在2005年底各大厂商都纷纷对闪存芯片和内存芯片进行扩容时,Apple采用闪存的ipod Nano已经拥有高达4GB的容量,而且价格相对于几年前动辄几十万美元的固态硬盘来说简直是低廉地惊人。另一方面,以闪存芯片作为载体的各种存储卡如CF、SD等价格也一跌再跌,今天一片2GB的CF卡不足千元!这一切都在告诉我们,硬盘的大容量优势正在逐步被闪存、内存芯片所代替。

2005年底的时候,Gigabyte更是试验性地推出i-RAM产品。所谓i-RAM实际上就是一个SATA接口的DDR控制器,用户在上面插入内存,就能享受固态硬盘带来的惊人速度。在I-RAM测试中,以内存作为数据存储媒介让SATA 150MB/s的接口速率成为瓶颈。在2006年以闪存或者内存作为存储媒介的固态硬盘必将在高端领域大展拳脚。也许PC告别机械化存储的时代为期不远了。

3.垂直记录迎来的高密度时代

硬盘尽管从速度、稳定性方面都不如后辈,不过硬盘的大容量优势却是相当明显的。在2005年内所有硬盘厂商都推出了单个500GB容量的硬盘。可惜硬盘容量(也就是存储密度)的提升并不是毫无障碍的。硬盘存储密度发展到今天遇到最为棘手的困难还是超磁效应。

所谓超磁效应,就是指的磁单元在高密度和很小的体积下,其自身的磁场特性将会无法维持而彻底消失。硬盘上每存储1bit数据都对应盘片上一个磁单元。在硬盘体积不变的情况下要提升容量,就必须提升磁单元的密度和体积。于是,超顺磁性效应(Superparamagnetic Effect)出现了!超顺磁性效应将会使硬盘无法保存数据,或者让数据存储变得非常不稳定。

就在硬盘遭遇存储密度瓶颈的时候,垂直记录(Perpendicular Recording)技术横空出世!通过应用垂直记录技术,硬盘的存储密度还能够再次提升10倍!从而凭借容量优势在未来夺得一席之地。那垂直记录技术有什么神奇之处能让我们突破超顺磁性效应?

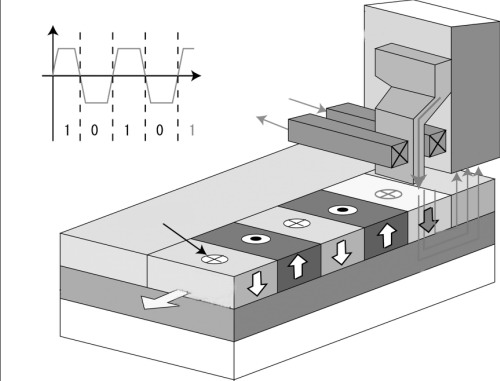

在垂直记录技术推出以前,硬盘的磁单元是沿着盘片旋转的方向水平排列,并且以磁极相邻、首尾相接的顺序从磁头下方通过。整整一圈下来,就是一个磁道,盘片上的所有磁道都是同心圆,水平分布在盘片上的。要提升密度就必须把磁单元的体积缩小。磁单元体积缩小之后所拥有的磁力将会明显下降,如果此时磁单元的磁力过小,则一点点温度变化或者磁场影响都将会令它无法保持原有的磁性,数据也会因此丢失。

而在使用垂直记录技术之后,磁单元被竖了起来,不再躺在盘片上了。这就好比我们将原来水平放置的书本重新垂直排列——这样书架上自然能够容纳更多的书本。竖起来的磁单元尽管从水平上来看占据的体积极大缩小,但是在垂直方向上磁单元的体积保持和现有体积持平,甚至在未来磁单元的体积还有可能增加。存储密度的增加,却不会让磁单元的体积进一步缩小,这也从根本上避免了超顺磁性效应的发生。

要适应垂直记录技术的特性,硬盘写入磁头的构造必要进行相应的改动,以产生磁化方向垂直于盘片表面的磁场。垂直记录磁头和原有的水平记录磁头有着很大的不同。水平记录磁头的信号极(Signal Pole)很窄,磁通量密度较高,这样就能让信号极下方的磁单元磁性发生翻转,从而记录数据。而垂直记录技术磁头的返回极(Return Pole)很宽,磁通量密度较低,这样就可以避免返回极下方的磁单元发生翻转。另外,由于磁单元从原本“躺着”的姿势变成了“站着”的姿势,所以垂直记录技术硬盘的存储盘片也与普通硬盘完全不同,垂直记录技术的硬盘盘片的磁层远厚于现在的普通盘片,同时还需要在磁层下面加入软磁底层以保证写入数据时的稳定性。

4.取长补短的HHD

微软和Samsung在2005年WinHEC会议上宣布联手推出一种叫做Hybird Hard Disk(以下简称HHD)的产品。这款产品从本质上来看几乎就是硬盘和闪存的融合产品。HHD在存储大量数据方面,采用了普通的温彻斯特原理的硬盘进行存储。而与普通硬盘不同的是,HHD还集成了1Gbit(即128MB)的闪存芯片,如此大容量的闪存芯片使得HHD在工作的时候不需要长时间保持磁盘盘片的快速旋转。在开机和关机的时候,系统也可以直接从闪存中读出数据从而实现快速启动。

在微软的规划中,HHD除了保持普通硬盘所必备的控制芯片、盘体、缓存等还将加入NV RAM区域。这个NV RAM区域将有64MB~128MB容量的高速闪存构成,由于闪存在断电后并不会丢失数据,因此有着和硬盘一样的非易失性。在系统发出存储请求之后,HHD将会启动盘片然后找到数据,最后把数据写入128MB的闪存中,而系统则通过SATA、PATA接口访问闪存中的存储数据。由于在绝大部分应用中需要连续存储的数据都很少超过128MB,因此HHD的机械部分在完成对闪存部分的数据填充之后便会停止旋转,直到收到下一次存储请求。

HHD带来的另外一个好处就是能显著降低功耗。众所周知硬盘是整个PC系统中出名的耗电大户。对于笔记本电脑来说除了CPU就数硬盘最耗电了。HHD在工作的时候硬盘主轴马达并不是长时间转动,而闪存芯片工作的能耗很低,这样就能显著降低硬盘的能耗。闪存的引入还大幅提升了HHD的平均无故障工作时间。许多硬盘损坏的原因在于主轴马达磨损或者是读写时遇到震动使得磁头划伤盘片。由于HHD并不需要长时间旋转盘片,故发生这样故障的几率大大降低。最后,由于HHD绝大部分时间都是在读取128MB容量闪存,所以在扛震性方面HHD也将远远超过传统硬盘。

三、光存储器新技术

在2006年高清视频全面普及的时候,DVD将会迎来它的继承者——HD DVD和BD。而十年一轮的视频存储格式大战也将于2006年展开。值得注意的是,在蓝色继承者你死我活的争夺背后,还有着技术更为超前的全息光盘虎视眈眈。2006年对于光存储设备来说充满了变数,你准备将你的数据存储在什么样的光盘上?

1.十年修行成正果——DVD存储全面普及

在2005年几乎所有新上市的DVD刻录机都能够同时支持DVD+R、DVD-R两大阵营。这种刻录机也被人们称作DVD Dual。同时提供对两大阵营的兼容毫无疑问会给用户带来极大的方便。随着刻录机产品的日益同质化,DVD刻录机厂商开始纷纷追捧另外一个新的概念DVD-RAM,并且借此推出通杀所有DVD刻录盘格式的DVD SuperMulti刻录机标准。

事实上DVD-RAM的诞生已经有很长一段时间,过去由于DVD-RAM的高成本和复杂的架构使得DVD-RAM更多地用在了光盘库等高端领域。近几年来随着DVD刻录盘价格的下降和DVD刻录机控制芯片/侍服机构的日益完善,DVD-RAM才逐步走向前台为世人所知。

相对于DVD-RW/DVD+RW等可擦写DVD光盘标准来说,DVD-RAM有着自身独特的优势。DVD-RAM最大的优势在于使用方便。和其他DVD刻录盘需要专门的刻录软件不同,DVD-RAM能够直接支持FAT32、UDF等文件格式。在你把DVD-RAM盘片放入对应的刻录机之后,你就能在Windows XP下像使用硬盘那样对DVD-RAM光盘进行格式化。写入数据的时候,也只需要将数据直接复制粘贴就万事大吉,根本不需要借助Nero等工具。

DVD-RAM在数据写入方面也有较DVD+RW和DVD-RW更好的安全性。DVD-RAM拥有完整的缺陷管理功能,同时还能在写入的时候对数据进行校验从而保证数据的完整性。随着DVD SuperMulti刻录机大量问世,2006年,将会有更多人使用DVD-RAM进行数据记录。

除了DVD-RAM将会在2006年被大家熟知之外,DVD+RW DL也有望在2006年问世。尽管DVD+R DL标准已经推出多时,但由于较高的盘片 价格使DVD+R DL始终无法普及。而DVD+RW DL由于可以多次擦写使用,所以很可能会比DVD+R DL更为流行。支持DVD+RW DL标准的刻录机有望在2006年全面上市。

2.蓝色继承人之争——BD vs HD DVD

光存储设备似乎每过10年就会进入新的轮回。10年前DVD格式大战,SONY倡导的MMCD败北,不得不和东芝为首的SD阵营合并,从而诞生了今天广泛使用的DVD。随着高清晰度视频浪潮的掀起,DVD所能提供的最大不到10GB的容量已经开始捉襟见肘。要存储一部1080P标准的高清视频电影最少需要动用23GB的存储空间。DVD显然难当此任。

于是SONY连同松下等业界巨头共同推出了基于蓝色激光记录技术的下一代光盘系统——Blu-ray Disc(以下简称BD)。由于拥有十多家业界厂商支持,BD刚刚问世就受到了广泛的关注。在对BD的支持问题上,SONY和松下两家死对头更是历史性地走到了一起。正当人们以为下一代光盘继任者非BD莫属的时候,DVD时代霸主东芝和NEC竟然另起炉灶,推出了AOD,并且在随后将AOD改名为HD DVD。

为什么下一代光盘系统都采用蓝紫色激光,其实答案很简单。激光也和我们日常看到的可见光一样具备不同的波长。而蓝紫色激光的波长更短,这样就能够制造出存储密度更大、读取速度更准确的光存储设备。

虽然同样使用蓝紫色激光,但HD DVD和BD走的是两条截然不同的道路。单面单层的HD DVD的容量只有15GB容量,而单面单层的BD却有着23GB的容量!

不要小看了8GB的差异,按照标准电影长度132分钟来看,记录1080P清晰度、使用MPEG-2编码格式之后输出的影片容量为21.3GB,如果配上字幕和互动控制部分,单面单层BD 23GB的容量正好够用。要在15GB的HD DVD中放入这样的视频必须采用更为复杂且轻微降低画质的编码方案,当然我们也可以使用单面双层HD DVD。

在存储容量方面BD有着压倒性的优势,而在制造成本方面HD DVD却明显强于BD。由于HD DVD采用了和DVD一样的0.6mm基版厚度,因此HD DVD能够沿用现有的生产线,这样光盘制造商就不需要彻底重新添置新的生产线。反观BD则因为采用0.1mm的基版厚度所以需要专门的生产线,而0.1mm的基版厚度也使得制造成本显著提升。据有关消息透露,BD的制造成本很可能达到HD DVD的1.5倍~2倍。

和其他IT标准不同,光盘格式标准的生死大权往往掌握在好莱坞制片商的手中。2005年底包括华纳兄弟、派拉蒙在内的好莱坞重量级制片商都纷纷倒戈投向BD阵营。此时,Intel和微软则因为BD无法支持限制拷贝功能而宣布加入HD DVD阵营。至此,BD联盟争取到了几乎所有好莱坞主要制片发行商支持,而HD DVD在IT领域则多了2个强大的盟友。面对如此突变,业界普遍认为BD阵营因为有着明显的片源优势将会在未来的竞争中占据上风。

3.沉默中的爆发——全息光盘崭露头角

就在BD和HD DVD斗得你死我活的时候,它们的接班人也悄然现身。研究了近40年的全息存储技术在近期获得了长足的进步。

早在上世纪40年代,英国科学家为了提升电子显微镜的分辨率而提出了全息技术。没过多久激光器的出现便使全息记录成为可能。在随后的几十年间,人们对于全息存储的研究就从来没有间断过。2005年两家从事全息光存储研究的机构InPhase和Optware纷纷展出了他们实用化的全息存储技术。如果按照现在12cm光盘体积来计算,一张同等体积的全息光盘将能获得200GB以上的存储空间!

全息光盘采用了和当今所有光盘不同的数据存储方式。传统的光盘系统是通过激光照射在沟槽上从而获得计算机所需要的01数据。而全息光盘则是使用图像来存储数据。相信许多人在日常生活中都见过雷射防伪标签,这种标签会根据入射光角度的不同而产生不同的图案,这就是全息图像的特性。全息光盘也正是借助了这样的原理来记录数据。

在全息光盘记录和读取数据时,首先会将数据编码为二维图像,然后在通过各种运算生成有规则的全息图案。随后这个全息图像会被记录(压印)到全息光盘中的每个波导层中形成次微米级的凹凸图案(即全息图案)。

在读取时,全息光盘驱动器先用激光束聚焦于全息光盘中特定的波导层底部,此时会在波导层中传播,并借助凹凸图案进行散射,散射的光线会在波导层上方与之平行的平面上形成二维图像,此时一个CCD便会将这个图案拍下来送入电脑,然后再根据一定的规则进行解码就能获得原始数据。全息光盘最为奇妙的地方是根据入射光线、入射波导层位置的不同产生不同的图像,一张全息光盘因此能够记录海量的信息,与此同时由于每次读取的是一个二维图像,其中能解码出大量的数据,所以全息光盘的读取速度高得惊人。

2005年10月,日本OPTWARE宣布将会在2006年上市旗下的全息光盘(Holographic Versatile Disc)。OPTWARE首次推向市场的全息光盘技术能够在一张信用卡大小的面积上存储30GB的数据。而全息光盘技术的另外一家研究厂商Inphase更是在1平方英寸面积,类似桑丝线大小可完成200Gbit的数据存储,这样的存储密度和硬盘相比都还要高50%。InPhase宣称在2009年将会上市1.6TB(1TB=1024GB)容量和DVD大小相同的全息光盘产品。

全息存储技术凭借独特的特性和惊人的存储密度即将成为未来光盘系统的接班人。事实上无论是BD还是HD DVD,在2005年之后都将会感受到全息存储技术离我们越来越近的强大压力。